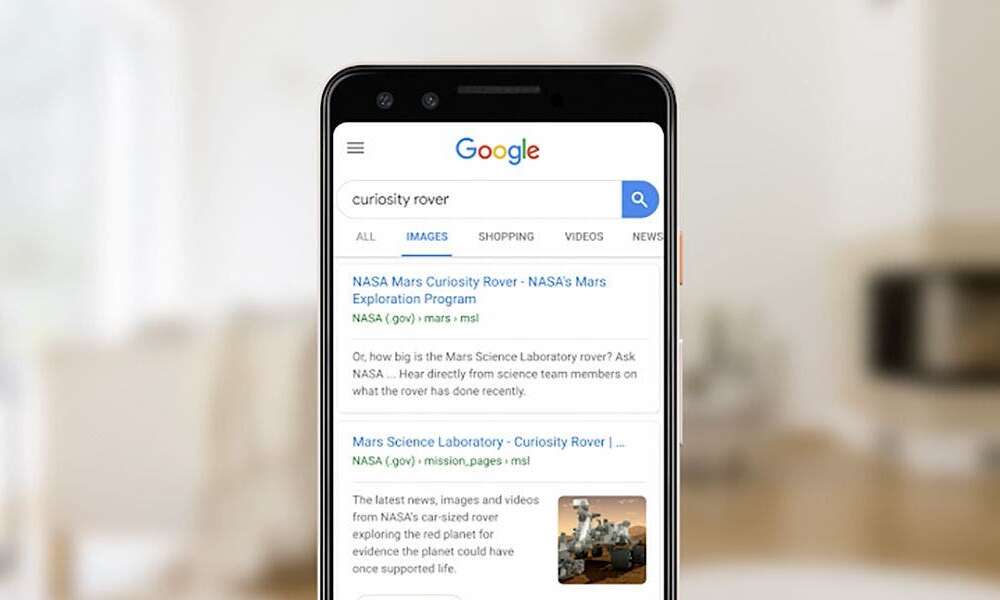

Google incorpora la realidad aumentada a las búsquedas

Con la realidad aumentada es posible ver e interactuar con objetos 3D desde el buscador de Google y obtener respuestas visuales a preguntas visuales

En su conferencia anual Google I/O la compañía mostró un anticipo del futuro de las búsquedas con la incorporación de funciones de visión artificial y de realidad aumentada a través del buscador de Google y de Google Lens.

Estas funciones utilizan la cámara del móvil para superponer información a la imagen, objetos en 3D y contenido en el entorno real cuando se capta a través de la cámara del móvil.

De este modo, explican desde Google, el usuario obtiene respuestas visuales a preguntas visuales; como ejempló se mostró el caso de una búsqueda relativa al tamaño del tiburón blanco.

«La gente recurre a Google para hacer miles de millones de preguntas cada día,» dice Sundar Pichai, CEO de Google. «Y podemos hacer más para ayudarle a encontrar la información que necesita mediante el aprendizaje automático, el reconocimiento de imagen y la realidad aumentada. Porque a veces la mejor manera de entender la información es viéndola.»

El resultado ya no será solo una cifra (6 metros) sino que la realidad aumentada superpone una imagen 3D del tiburón en el salón de casa para que el usuario explore detalles visuales y tenga una sensación de escala, de cuán grande es un tiburón de 6 metros.

Imagen: Google

Recientemente Google ha comenzado a explorar el uso de la realidad aumentada en su aplicación de mapas Google Maps, para facilitar al usuario a situarse en el entorno y ayudarle a conocer qué camino deben seguir combinando las indicaciones de la aplicación con imágenes del entorno, que de este modo puede orientarse comparando lo que ve a su alrededor con lo que debería estar viendo. Esta función ya está disponible en versión «de prueba» en Google Maps.

La app de análisis de imagen Google Lens funciona ahora en más dispositivos

La app Google Lens funciona en cierto modo de modo inverso: utiliza el aprendizaje automático y la inteligencia artificial para analizar lo que está captando la cámara del móvil y convertirlo en información útil para el usuario.

El ejemplo evidente es traducir textos entre idiomas: dirigiendo la cámara del móvil hacia un texto en inglés Google Lens muestra superpuesta la traducción del texto, como si estuviera escrito en el idioma del usuario.

Imagen: Google

El mismo principio es aplicable para la lectura automática y en voz alta de carteles y textos (para personas con dificultad de visión o de lectura) que además facilita la búsqueda del significado de palabras: basta tocar en una palabra específica para buscarla y aprender su definición.

La tecnología de análisis de imagen de Google Lens también es aplicable a objetos e información. Por ejemplo dirigiendo la cámara del móvil hacia un monumento mostrará información relacionada con él; o captando con la cámara la información de acceso a una red wifi para que el móvil configure automáticamente esa red.

Otro ejemplo, mostrado en la conferencia Google I/O va un paso más allá: «Si estás en un restaurante y no sabes qué pedir utiliza Google Lens para analizar la carta y la app identificará cuáles son los platos más populares, mostrará fotografías de otros usuarios muestren cuál es su aspecto e incluso mostrará qué dice la gente sobre cada plato en las reseñas y comentarios de Google.»

La tecnología de Google Lens, disponible como app en Play Store, se integra también con las aplicaciones Google Fotos para identificar objetos y sujetos, y en Google Assistant, el asistente inteligente de Google.